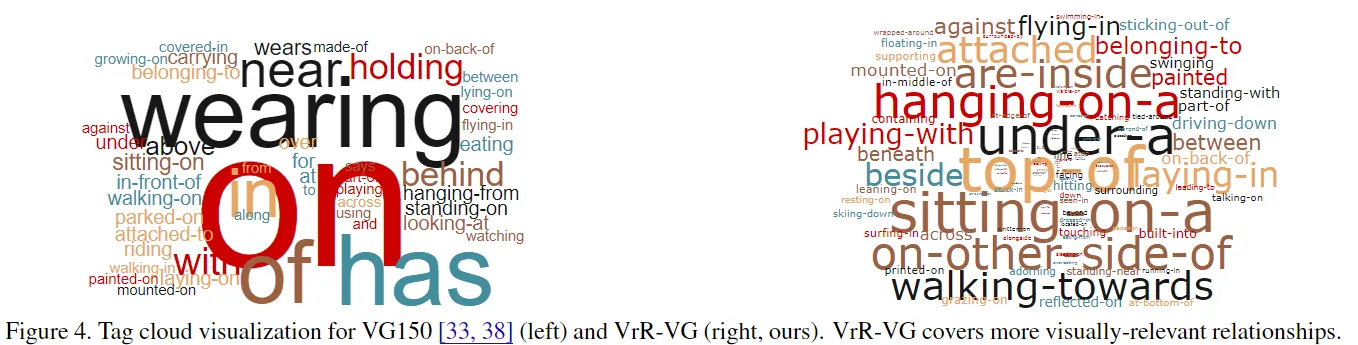

场景图/视觉关系建模的数据中存在大量偏差: 只看检测框的相对位置就能猜关系(例如 A 在 B 上方→on),或只看类别标签就能猜关系(人+衣服→wear)。 这类关系被称为 visually-irrelevant relationships:模型即使不看图像内容也能得到不错的关系预测。 VrR-VG 的核心做法是训练一个"作弊模型"——仅输入框与类别、不输入图像内容——来识别哪些关系是可被这种偏差预测出来的。 然后把这些样本从训练数据中剔除,留下真正需要视觉证据才能判断的 visually-relevant relationships,从而提升关系学习对表征的增益。

1. 为什么这个问题严重:模型学到的是偏见,不是视觉语义

关系学习常被当作提升视觉表征的辅助任务,但如果训练信号主要来自"位置/标签捷径",模型会更倾向于记忆统计规律。 最终你得到的是一个很会猜数据集分布、但不真正理解视觉内容的系统。

2. 偏差长什么样:两类典型捷径

常见偏差包括: (1)空间位置偏差:框在上方就猜 on; (2)标签语义偏差:人-衣服就猜 wear。 两者共同点是:不依赖像素证据。

3. VrR-VG 的反直觉但有效策略:先学"怎么作弊",再过滤数据

VrR-VG 的关键在于数据过滤而不是更复杂的模型:用一个只看框与类别的小网络,衡量关系是否可由偏差解释。 能被解释的关系就被认为对学习视觉语义帮助有限(甚至有害),从训练集中剔除。

4. Key Insights:一种通用的"反事实数据诊断"思路

VrR-VG 的范式可以迁移到很多任务: 先构造一个“不该成功但会因为偏差而成功”的基线(只用捷径信息), 再用它标记/过滤训练信号,从而把学习压力推回到真正的因果证据上。

English Summary

VrR-VG addresses dataset bias in visual relationship learning and scene graph prediction. Many relationship labels can be predicted without looking at pixels, using only object categories and bounding-box geometry. Training on such shortcuts limits representation learning and harms generalization.

Core Idea

Train a bias-only model that ignores visual appearance and predicts relationships from labels and box configurations. Relationships that are easy for this bias model are treated as visually irrelevant and filtered out. The remaining training signal emphasizes visually grounded relationships that require image evidence.

Practical Takeaways

Building an explicit "shortcut baseline" is an effective way to diagnose and reduce spurious correlations. Filtering or reweighting based on shortcut predictability can make auxiliary tasks more useful for representation learning.