IcoCap 的核心不是"把图像和视频一起训",而是 Image-Video Compounding:把高语义密度的图像帧以可控方式复合进视频序列,构造更强冗余与更难对齐的训练样本。 这样会制造一种看似噪声但长期有益的干扰:模型不能偷懒只盯最清晰单帧,而必须学会跨帧整合与抑制诱导帧。 从正激励噪声(pi-noise)的视角,这是一种"受控的强干扰注入",用于降低任务的捷径解并强化真正需要的时序语义能力。

1. 为什么"多加图像数据"不一定有效

图像语义密度高、对齐强、噪声小;视频天然冗余多、对齐弱。 直接混合训练往往让模型更偏好学习"更容易"的图像信号,而视频任务里真正困难的时间整合与抗冗余并没有被强化。

2. IcoCap 的关键动作:制造强但可控的冗余干扰

复合图像帧会引入“强诱导”:模型会很想只描述那张清晰图片。 但训练目标仍要求总结整段视频的语义,因此优化过程会迫使模型学会抑制诱导帧、整合多帧证据。

3. pi-noise 视角:噪声不一定是坏事

关键区分在于噪声是否可控、是否把学习压力推向更本质的能力。 IcoCap 不是随机噪声,而是语义很强、很诱人的帧——这类干扰能暴露并惩罚"只看单帧"的捷径。

4. Key Insights:很多"聪明的数据增强"都可以用 pi-noise 理解

当一个增强策略让任务变难,但同时迫使模型学习更稳健的因果证据时,它就更像是正激励噪声。 这种视角对设计视频理解/对齐/偏好优化的数据与奖励很有帮助。

English Summary

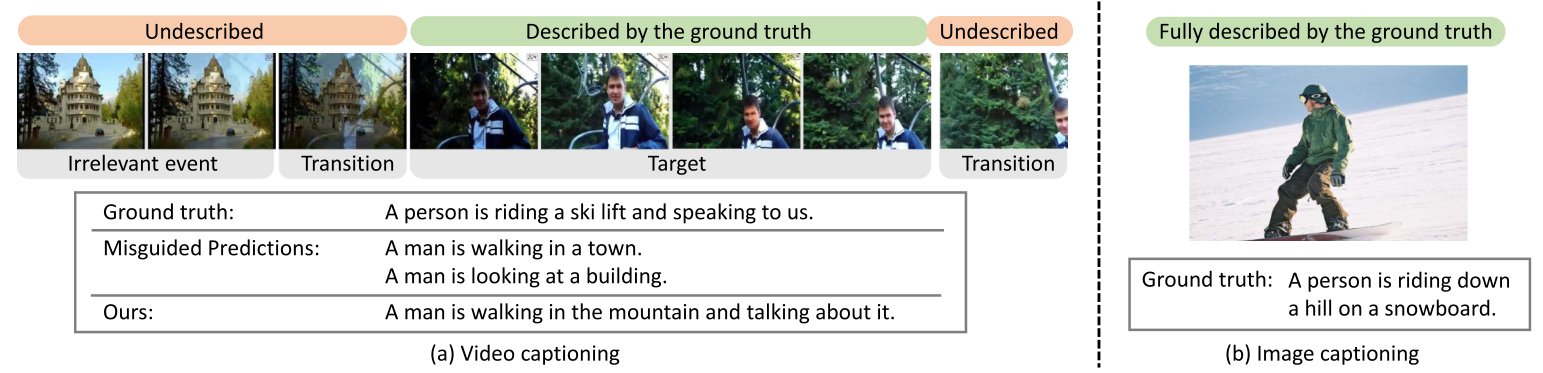

IcoCap explores a counterintuitive route to improve video understanding and captioning: injecting structured, semantically strong distractions rather than merely adding more clean data. The method uses image-video compounding to create harder training examples that force temporal integration.

Problem

Video models can over-rely on a few salient frames and ignore temporal evidence. Naively mixing image data may reinforce single-frame shortcuts instead of improving temporal reasoning.

Core Idea

Compound images into videos to produce strong but controllable redundancy. The compounded frames act as tempting signals that can mislead a shortcut model, encouraging the model to learn robust aggregation over time.

Practical Takeaways

Carefully designed distractions can improve robustness when they expose and penalize shortcut solutions. For video tasks, training signals that require multi-frame evidence are often more valuable than simply increasing data volume.